La burocràcia invisible (Kafka 2.0): Quan la decisió perd el rostre

Manel Hernández

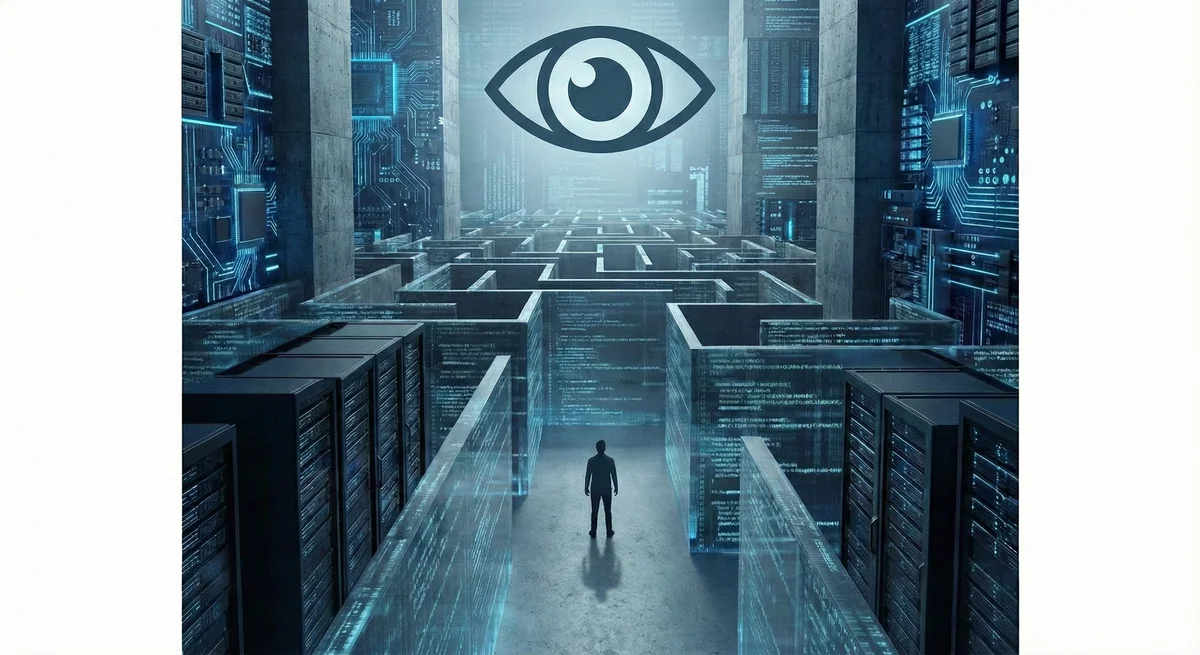

Manel Hernández Sovint tinc la sensació que estem reescrivint El Procés de Kafka, però aquesta vegada l’acusat no s’enfronta a tribunals laberíntics ni a funcionaris grisos, sinó a un silenci digital absolut.

Cada cop més decisions que determinen la nostra vida —la concessió d’una hipoteca, una beca menjador, una inspecció fiscal o el cribratge d’un currículum— les pren “algú” que no té rostre. Ja no hi ha una persona a l’altra banda de la finestreta; hi ha un algoritme negre. Decideix ràpid, no dona raons i, el més greu de tot, ningú n’assumeix la responsabilitat.

L’eficiència com a excusa per a l’opacitat Ens van vendre l’automatització com la fi de l’arbitrarietat humana. Ens van dir que la màquina seria neutral. Però la realitat és que l’arbitrarietat no ha desaparegut; simplement s’ha amagat dins d’una caixa negra.

Quan un sistema ens classifica com a “risc” o ens denega un tràmit per un “patró anòmal”, i l’única resposta que rebem és un codi d’error sense explicació, estem perdent un dret fonamental: el dret a entendre. Una societat sense traça de raons és una societat sense justícia. Si no sé per què se m’ha jutjat, no em puc defensar. L’eficiència del sistema s’ha comprat al preu de la nostra indefensió.

La persona no és un patró de dades El perill d’aquesta nova burocràcia és que ens redueix a vectors de dades. Ens tracta, de nou, com a insums: peces d’informació a processar per optimitzar una mètrica de rendiment.

Però la dignitat humana resisteix a ser simplificada. Darrere d’un retard en el pagament de l’IVA pot haver-hi un frau, sí, o pot haver-hi una història de supervivència, un error administratiu o una crisi personal. Un humà pot entendre el matís; un model entrenat amb dades històriques (i esbiaixades) només veu el patró. Si eliminem la mirada humana de l’equació, eliminem la possibilitat de l’excepció, de la compassió i del context.

Tornar al Rostre: Copilot, no Pilot Lévinas deia que l’ètica s’encén quan mirem el Rostre de l’Altre. La seva nuesa ens obliga a respondre. El problema de la IA burocràtica és que elimina el rostre. Ens converteix en abstraccions.

La meva proposta de “Tecnohumanisme pràctic” no és rebutjar la tecnologia, sinó posar-la al seu lloc: el de Copilot. Necessitem sistemes que ens ajudin a gestionar la complexitat, però que deixin la decisió final —especialment quan aquesta afecta la vida de les persones— en mans humanes. Necessitem “fricció ètica”: pauses conscients on algú es pregunti si el que diu la màquina és just, no només si és ràpid. Dret a motiu comprensible: cada decisió ha de venir amb una motivació breu i camí d’apel·lació.

Hem d’exigir sistemes que siguin caixes de vidre, no caixes negres. Perquè una decisió sense explicació no és una decisió intel·ligent; és només una sentència. I jo em nego a viure en un món on l’eficiència valgui més que el dret a ser escoltat.

La Reflexió IAvers

"El veritable perill no és que la màquina s'equivoqui, sinó que no hi hagi ningú a l'altre costat per corregir-ho. Hem passat de la burocràcia grisa al silenci digital absolut. El principi: A IAvers defensem el Dret a la Rèplica Humana: darrere de cada decisió algorítmica hi ha d'haver un responsable amb nom i cognoms."

Preguntes freqüents

Com pot la IA reduir la burocràcia empresarial?

La IA pot automatitzar processos repetitius com validacions de documents, gestió d'aprovacions i seguiment de tràmits. Això allibera temps per a tasques amb més valor afegit.

És segur delegar decisions burocràtiques a la IA?

Amb supervisió humana adequada, sí. A IAvers implementem polítiques que asseguren que decisions crítiques sempre tenen aprovació humana final.

Quins processos burocràtics es poden automatitzar primer?

Els més adequats són: classificació de documents, enviament d'emails repetitius, recordatoris automàtics i validacions bàsiques. Després es poden escalar a processos més complexos.